🌐 Ética de la IA: principios, desafíos y el futuro

La Inteligencia Artificial (IA) está transformando las industrias, la toma de decisiones y la vida cotidiana. Pero este poder conlleva responsabilidad. A medida que los sistemas de IA se vuelven más capaces y autónomos, se intensifican las preocupaciones sobre la imparcialidad, la responsabilidad, la privacidad y el sesgo. La ética de la IA guía el desarrollo y la implementación de la IA de manera que se alineen con los valores humanos y las normas sociales.

📌 Por qué es importante la ética de la IA

- Evitar sesgos: evite resultados discriminatorios detectando y corrigiendo sesgos en los datos y algoritmos de entrenamiento.

- Protección de la privacidad: administre los datos confidenciales de manera responsable para mantener la confianza.

- Transparencia: asegúrese de que las decisiones de IA puedan entenderse y explicarse.

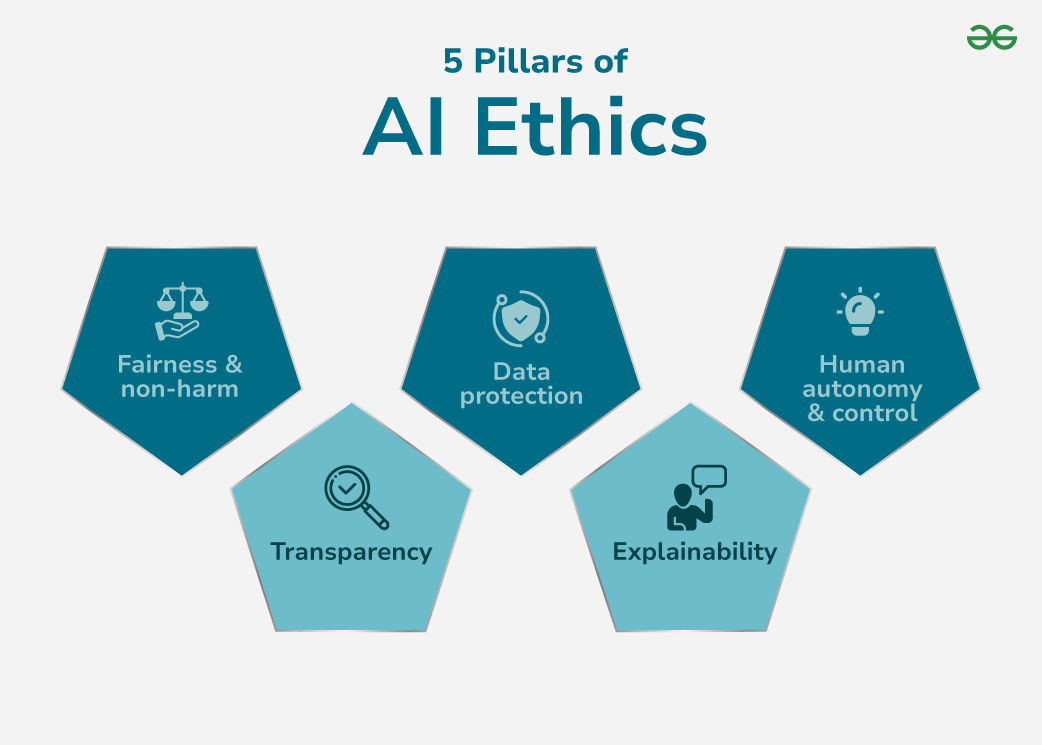

🏛 Los 5 pilares de la ética de la IA

Estos pilares forman la base de una IA confiable. ### 1. Justicia y no discriminación

La IA debe evaluar basándose en criterios relevantes, no en raza, género o ubicación.

### 1. Justicia y no discriminación

La IA debe evaluar basándose en criterios relevantes, no en raza, género o ubicación.

- Desafíos: Los datos de capacitación sesgados pueden conducir a una discriminación sistémica.

- Soluciones: utilice diversos conjuntos de datos, herramientas de detección de sesgos y algoritmos que tengan en cuenta la equidad.

2. Transparencia

Debemos entender cómo la IA llega a sus conclusiones.

- Desafíos: Los modelos complejos, como las redes neuronales profundas, funcionan como “cajas negras” opacas.

- Soluciones: invierta en IA explicable (XAI), árboles de decisión visuales y métodos de atribución de factores.

3. Protección de datos

Proteger los datos personales del mal uso.

- Desafíos: Riesgo de infracciones, uso no autorizado o incumplimiento normativo.

- Soluciones: políticas de consentimiento claras, almacenamiento cifrado y control de acceso estricto.

4. Explicabilidad

Va más allá de la transparencia: garantizar que las explicaciones sean significativas para las personas afectadas.

- Desafíos: la complejidad técnica puede dificultar la comprensión de los no expertos.

- Soluciones: Simplifique los resultados en narrativas legibles por humanos y desgloses de decisiones.

5. Autonomía y control humanos

La IA debería ayudar, no reemplazar, la toma de decisiones humana.

- Desafíos: La dependencia excesiva corre el riesgo de perder la supervisión, especialmente en dominios críticos para la seguridad.

- Soluciones: Incluya siempre controles humanos en el circuito y opciones de anulación.

Retos éticos en la IA

- Opacidad: los modelos profundos carecen de transparencia, lo que dificulta las auditorías.

- Amenazas a la seguridad: Vulnerable a ataques adversarios, envenenamiento de datos y filtraciones.

- Sesgo algorítmico: el sesgo en los datos de entrenamiento conduce a resultados injustos.

- Brechas de rendición de cuentas: No hay una responsabilidad clara cuando la IA causa daño.

- Gestión de riesgos: la IA puede fallar de manera impredecible sin las salvaguardias adecuadas.

📜 Código de ética de la IA

- Apertura y transparencia: lógica del modelo de documento, control de versiones e historial de decisiones.

- Estándares de seguridad de datos: utilice cifrado, autenticación y acceso con privilegios mínimos.

- Justicia y equidad: Auditoría y prueba de paridad demográfica e igualdad de oportunidades.

- Responsabilidad y rendición de cuentas: Asigne una propiedad ética clara en cada etapa.

- Seguridad y bienestar: incluya mecanismos de seguridad y estrategias de reversión.

Implementación de IA ética

- Promover la transparencia: utilizar modelos interpretables y mantener una documentación exhaustiva.

- Garantizar la seguridad: cifra todos los datos almacenados/transferidos, utiliza el acceso basado en roles.

- Reducir el sesgo: audite periódicamente los conjuntos de datos, reequilibre la representación y realice un seguimiento de las métricas de equidad.

- Definir responsabilidad: implementar puntos de control éticos en el ciclo de vida de la IA.

- Fortalecer la seguridad: realice pruebas de estrés en casos extremos y simulaciones de escenarios de alto riesgo.

Pasos hacia una IA más ética

- Establecer pautas éticas claras.

- Desviar conjuntos de datos y algoritmos antes de la implementación.

- Respetar el consentimiento informado y los derechos sobre los datos de los usuarios.

- Integrar el pensamiento ético desde la ideación hasta el seguimiento posterior al despliegue.

- Crear pistas de auditoría para los procesos de toma de decisiones.

🔮 El futuro de la ética de la IA

- Investigación en evolución: crecimiento de XAI, mitigación de sesgos y marcos de gobernanza de IA.

- Reglamentación más estricta: están surgiendo leyes internacionales de IA y estándares de cumplimiento.

- Nuevos dominios, nueva ética: los vehículos autónomos, la medicina predictiva y la aplicación de la ley basada en inteligencia artificial requerirán una supervisión ética dedicada.

La IA ética se trata de confianza. Al incorporar equidad, transparencia, responsabilidad y seguridad en los sistemas de IA, podemos garantizar que la tecnología sirva a todos: no solo a unos pocos privilegiados.