Copyright to wallhaven

1348 文字

7 分

人工知能の倫理

🌐 AI 倫理 — 原則、課題、将来

人工知能 (AI) は、産業、意思決定、日常生活を変革しています。 しかし、この力には責任が伴います。 AI システムの機能と自律性が高まるにつれて、公平性*、説明責任*、プライバシー、偏見に関する懸念が強まっています。 AI 倫理 は、人間の価値観や社会規範と一致する方法で AI の開発と展開を導きます。

📌 AI の倫理が重要な理由

- バイアスの回避 — トレーニング データとアルゴリズムのバイアスを検出して修正することで、差別的な結果を防ぎます。

- プライバシー保護 — 信頼を維持するために機密データを責任を持って管理します。

- 透明性 — AI の決定を理解して説明できるようにします。

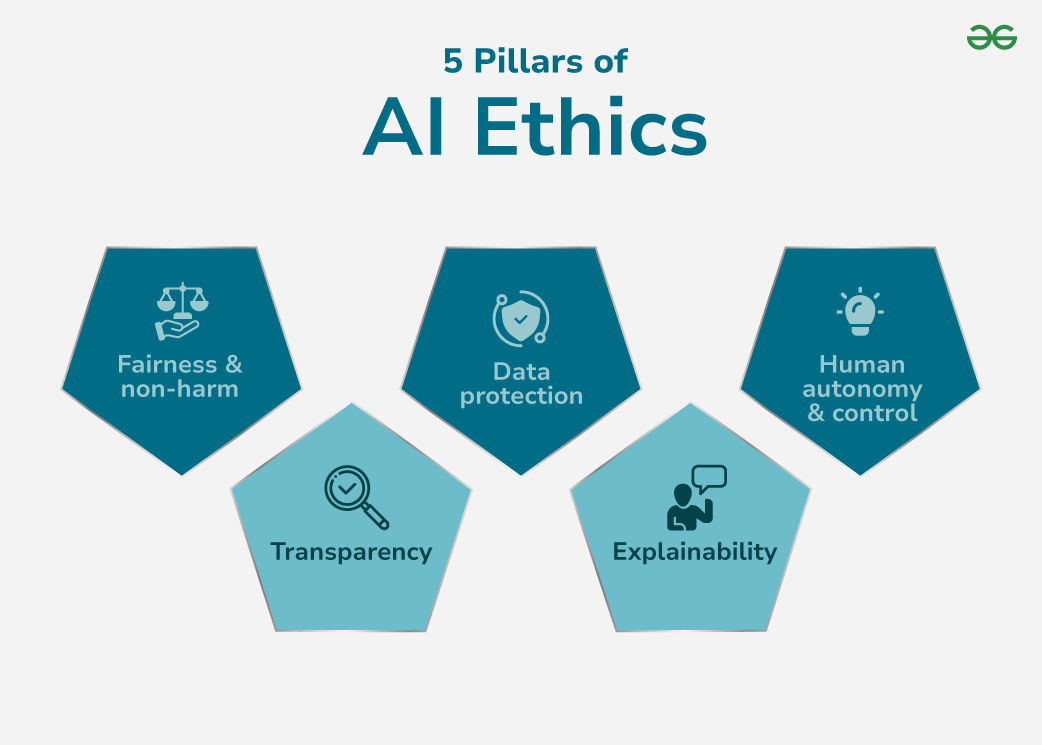

🏛 AI 倫理の 5 つの柱

これらの柱は、信頼できる AI の基盤を形成します。 ### 1. 公平性と差別の禁止

AI は、人種、性別、場所ではなく、関連する基準に基づいて評価する必要があります。

### 1. 公平性と差別の禁止

AI は、人種、性別、場所ではなく、関連する基準に基づいて評価する必要があります。

- 課題: トレーニング データに偏りがあると、組織的な差別が生じる可能性があります。

- ソリューション: 多様なデータセット、バイアス検出ツール、公平性を意識したアルゴリズムを使用します。

2. 透明性

私たちは、AI がどのように結論に達するかを理解する必要があります。

- 課題: ディープ ニューラル ネットワークのような複雑なモデルは、不透明な「ブラック ボックス」として動作します。

- ソリューション: Explainable AI (XAI)、視覚的な意思決定ツリー、および要因帰属手法に投資します。

3. データ保護

個人データを悪用から守ります。

- 課題: 違反、不正使用、または規制違反のリスク。

- ソリューション: 明確な同意ポリシー、暗号化されたストレージ、および厳格なアクセス制御。

4. 説明可能性

透明性を超えて、影響を受ける個人にとって意味のある説明を保証します。

- 課題: 技術的な複雑さにより、専門家以外の理解が妨げられる場合があります。

- ソリューション: 出力を人間が読めるナラティブと意思決定の内訳に簡素化します。

5. 人間の自律性と制御

AI は人間の意思決定に代わるものではなく、支援すべきです。

- 課題: 過度に依存すると、特に安全性が重要な領域において、監視が失われる危険があります。

- 解決策: 常に人間参加型コントロールとオーバーライド オプションを含めます。

AI における倫理的課題

- 不透明性: ディープ モデルには透明性が欠けており、監査が困難になります。

- セキュリティの脅威: 敵対的な攻撃、データポイズニング、侵害に対して脆弱です。

- アルゴリズムのバイアス: トレーニング データのバイアスは不公平な結果につながります。

- 責任のギャップ: AI が危害を及ぼした場合、明確な責任がありません。

- リスク管理: AI は、適切な安全策がなければ、予期せぬ形で失敗する可能性があります。

📜 AI 倫理規定

- 公開性と透明性: モデルのロジック、バージョン管理、意思決定履歴を文書化します。

- データ セキュリティ標準: 暗号化、認証、および最小特権アクセスを使用します。

- 公平性と公平性: 人口統計上の平等と機会均等を監査およびテストします。

- 責任と責任: あらゆる段階で明確な倫理的責任を割り当てます。

- 安全性と健康: フェールセーフ メカニズムとロールバック戦略を含めます。

倫理的な AI の実装

- 透明性の促進: 解釈可能なモデルを使用し、徹底的な文書を維持します。

- セキュリティの確保: 保存/転送されるすべてのデータを暗号化し、ロールベースのアクセスを使用します。

- バイアスを削減: データセットを定期的に監査し、表現のバランスを再調整し、公平性の指標を追跡します。

- 責任の定義: AI ライフサイクルに倫理チェックポイントを実装します。

- 安全性の強化: エッジケースのストレス テストと高リスク シナリオのシミュレーションを実行します。

より倫理的な AI に向けたステップ

- 明確な倫理ガイドラインを確立します。

- 導入前にデータセットとアルゴリズムをバイアス解除します。

- インフォームドコンセントとユーザーデータの権利を尊重します。

- 構想から導入後のモニタリングまで倫理的思考を統合します。

- 意思決定プロセスの監査証跡を作成します。

🔮 AI 倫理の未来

- 進化する研究: XAI の成長、バイアス緩和、AI ガバナンス フレームワーク。

- 規制の強化: 国際的な AI 法とコンプライアンス基準が出現しています。

- 新しい領域、新しい倫理: 自動運転車、予測医療、AI 主導の法執行には、専用の倫理監督が必要になります。

倫理的な AI は信頼に関するものです。 公平性、透明性、説明責任、安全性を AI システムに組み込むことで、一部の特権的な人々だけでなく、テクノロジーがすべての人に役立つことを保証できます。