Copyright to wallhaven

1152 字

6 分钟

人工智能伦理

🌐 人工智能伦理——原则、挑战和未来

人工智能 (AI) 正在改变行业、决策和日常生活。 但这种权力伴随着责任。 随着人工智能系统变得更加强大和自主,对公平、责任、隐私和偏见的担忧加剧。 人工智能道德以符合人类价值观和社会规范的方式指导人工智能的开发和部署。

📌 为什么人工智能道德很重要

- 避免偏见 — 通过检测和纠正训练数据和算法中的偏见来防止歧视性结果。

- 隐私保护 — 负责任地管理敏感数据以维持信任。

- 透明度 — 确保人工智能决策能够被理解和解释。

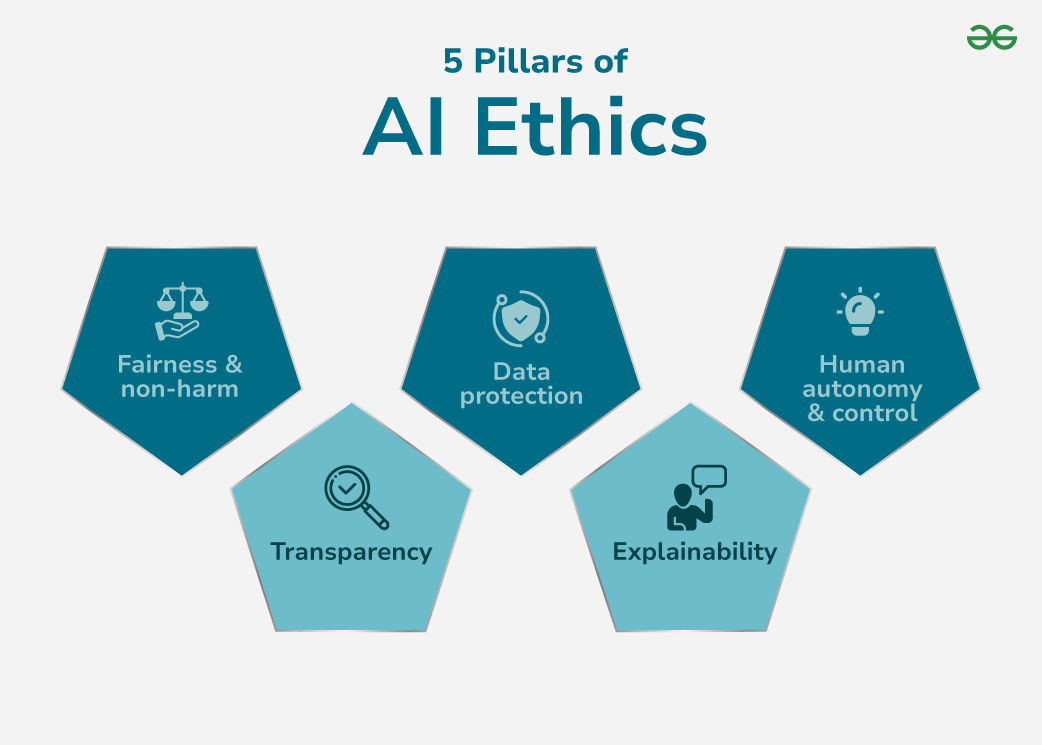

🏛 人工智能道德的 5 个支柱

这些支柱构成了值得信赖的人工智能的基础。 ### 1. 公平与非歧视

人工智能必须根据相关标准进行评估,而不是种族、性别或地点。

### 1. 公平与非歧视

人工智能必须根据相关标准进行评估,而不是种族、性别或地点。

- 挑战:有偏见的训练数据可能导致系统性歧视。

- 解决方案:使用不同的数据集、偏差检测工具和公平感知算法。

2. 透明度

我们必须了解人工智能如何得出结论。

- 挑战:像深度神经网络这样的复杂模型作为不透明的“黑匣子”运行。

- 解决方案:投资可解释的人工智能(XAI)、视觉决策树和因素归因方法。

3. 数据保护

保护个人数据免遭滥用。

- 挑战:违规、未经授权使用或不遵守法规的风险。

- 解决方案:明确的同意策略、加密存储和严格的访问控制。

4.可解释性

超越透明度:确保解释对受影响的个人有意义。

- 挑战:技术复杂性可能会阻碍非专家的理解。

- 解决方案:将输出简化为人类可读的叙述和决策分解。

5.人类自主与控制

人工智能应该协助,而不是取代人类决策。

- 挑战:过度依赖可能会导致失去监督,特别是在安全关键领域。

- 解决方案:始终包含人机交互控制和覆盖选项。

人工智能的道德挑战

- 不透明:深度模型缺乏透明度,使得审计变得困难。

- 安全威胁:容易受到对抗性攻击、数据中毒和破坏。

- 算法偏差:训练数据中的偏差会导致不公平的结果。

- 问责差距:人工智能造成伤害时没有明确的责任。

- 风险管理:如果没有适当的保障措施,人工智能可能会以不可预测的方式失败。

📜 AI 道德准则

- 开放性和透明度:记录模型逻辑、版本控制和决策历史记录。

- 数据安全标准:使用加密、身份验证和最低权限访问。

- 公平与公正:审核和测试人口平等和机会均等。

- 责任和问责:在每个阶段分配明确的道德所有权。

- 安全与福祉:包括故障安全机制和回滚策略。

实施有道德的人工智能

- 促进透明度:使用可解释的模型并维护完整的文档。

- 确保安全:加密所有存储/传输的数据,使用基于角色的访问。

- 减少偏差:定期审核数据集、重新平衡表示并跟踪公平性指标。

- 定义责任:在人工智能生命周期中实施道德检查点。

- 加强安全性:执行边缘情况压力测试和高风险场景模拟。

迈向更加道德的人工智能的步骤

- 建立明确的道德准则。

- 部署前对数据集和算法进行去偏。 3.尊重知情同意和用户数据权利。

- 整合从构思到部署后监控的道德思维。

- 为决策过程创建审计跟踪。

🔮 人工智能伦理的未来

- 不断发展的研究:XAI 的增长、偏见缓解和 AI 治理框架。

- 更严格的监管:国际人工智能法律和合规标准不断涌现。

- 新领域,新道德:自动驾驶车辆、预测医学和人工智能驱动的执法将需要专门的道德监督。

有道德的人工智能关乎信任。 通过将公平、透明、问责和安全嵌入到人工智能系统中,我们可以确保技术服务于所有人:而不仅仅是少数特权阶层。

### 参考AI_ethics_Wikipedia