Copyright to wallhaven

1152 字

6 分鐘

人工智能倫理

🌐 人工智能倫理——原則、挑戰和未來

人工智能 (AI) 正在改變行業、決策和日常生活。 但這種權力伴隨著責任。 隨著人工智能係統變得更加強大和自主,對公平、責任、隱私和偏見的擔憂加劇。 人工智能道德以符合人類價值觀和社會規範的方式指導人工智能的開發和部署。

📌 為什麼人工智能道德很重要

- 避免偏見 — 通過檢測和糾正訓練數據和算法中的偏見來防止歧視性結果。

- 隱私保護 — 負責任地管理敏感數據以維持信任。

- 透明度 — 確保人工智能決策能夠被理解和解釋。

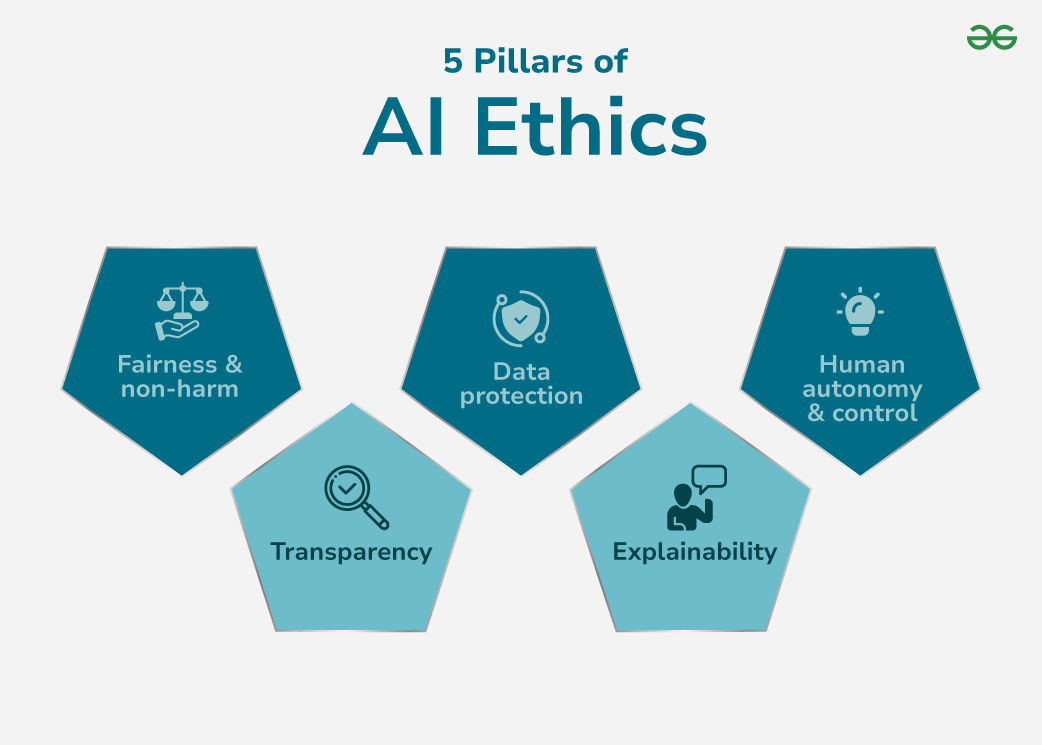

🏛 人工智能道德的 5 個支柱

這些支柱構成了值得信賴的人工智能的基礎。 ### 1. 公平與非歧視

人工智能必鬚根據相關標准進行評估,而不是種族、性別或地點。

### 1. 公平與非歧視

人工智能必鬚根據相關標准進行評估,而不是種族、性別或地點。

- 挑戰:有偏見的訓練數據可能導致系統性歧視。

- 解決方案:使用不同的數據集、偏差檢測工具和公平感知算法。

2. 透明度

我們必須了解人工智能如何得出結論。

- 挑戰:像深度神經網絡這樣的複雜模型作為不透明的“黑匣子”運行。

- 解決方案:投資可解釋的人工智能(XAI)、視覺決策樹和因素歸因方法。

3. 數據保護

保護個人數據免遭濫用。

- 挑戰:違規、未經授權使用或不遵守法規的風險。

- 解決方案:明確的同意策略、加密存儲和嚴格的訪問控制。

4.可解釋性

超越透明度:確保解釋對受影響的個人有意義。

- 挑戰:技術複雜性可能會阻礙非專家的理解。

- 解決方案:將輸出簡化為人類可讀的敘述和決策分解。

5.人類自主與控制

人工智能應該協助,而不是取代人類決策。

- 挑戰:過度依賴可能會導致失去監督,特別是在安全關鍵領域。

- 解決方案:始終包含人機交互控制和覆蓋選項。

人工智能的道德挑戰

- 不透明:深度模型缺乏透明度,使得審計變得困難。

- 安全威脅:容易受到對抗性攻擊、數據中毒和破壞。

- 算法偏差:訓練數據中的偏差會導致不公平的結果。

- 問責差距:人工智能造成傷害時沒有明確的責任。

- 風險管理:如果沒有適當的保障措施,人工智能可能會以不可預測的方式失敗。

📜 AI 道德準則

- 開放性和透明度:記錄模型邏輯、版本控制和決策歷史記錄。

- 數據安全標準:使用加密、身份驗證和最低權限訪問。

- 公平與公正:審核和測試人口平等和機會均等。

- 責任和問責:在每個階段分配明確的道德所有權。

- 安全與福祉:包括故障安全機制和回滾策略。

實施有道德的人工智能

- 促進透明度:使用可解釋的模型並維護完整的文檔。

- 確保安全:加密所有存儲/傳輸的數據,使用基於角色的訪問。

- 減少偏差:定期審核數據集、重新平衡表示並跟踪公平性指標。

- 定義責任:在人工智能生命週期中實施道德檢查點。

- 加強安全性:執行邊緣情況壓力測試和高風險場景模擬。

邁向更加道德的人工智能的步驟

- 建立明確的道德準則。

- 部署前對數據集和算法進行去偏。 3.尊重知情同意和用戶數據權利。

- 整合從構思到部署後監控的道德思維。

- 為決策過程創建審計跟踪。

🔮 人工智能倫理的未來

- 不斷發展的研究:XAI 的增長、偏見緩解和 AI 治理框架。

- 更嚴格的監管:國際人工智能法律和合規標準不斷湧現。

- 新領域,新道德:自動駕駛車輛、預測醫學和人工智能驅動的執法將需要專門的道德監督。

**有道德的人工智能關乎信任。 ** 通過將公平、透明、問責和安全嵌入到人工智能係統中,我們可以確保技術服務於所有人:而不僅僅是少數特權階層。

### 參考AI_ethics_Wikipedia